В этой записи я расскажу о ситуации, с которой может столкнуться владелец СДЛ – нарушение авторских прав и воровство контента с сайта. Странно, конечно, называть это «воровством», но так повелось.

Да и как это тухлое дело не назови, смысл не меняется. Сначала расскажу реальные истории, потом — о том, как бороться с ворами. В конце коротко опишу о методах защиты контента от ворующих подлецов.

Боремся с воровством контента

Мой друг писал статью 3 часа, старался. Опубликовал её на своем молодом сайте. А через месяц увидел, что его статью разместил какой-то пузатый сайт. Статью сграбили «как есть» вместе с картинками и оформлением. Никаких ссылок на источник не указали. Через некоторое время дружище пошел смотреть позиции в Яндексе по запросам этой статьи и увидел, что страница по ним вообще улетела за топ 100. Начал проверять выдачу по кускам текста из статьи, и в топе увидел только страницу сайта вора. Вот так-то.

Я тоже решил посмотреть, как обстоит дело с уникальностью моих статей. Проверил те статьи, которые в прошлом давали траф, а сейчас почему-то запросы потеряли позиции. И о чудо! (с) Такая же фигня..

Сначала проверил один сайт. Статьи, которые я публиковал еще в 2010 году, были «сворованы» и скопированы в 2012-2013г на другие ресурсы. Почему-то алгоритмы Яндекса (а кое-где и Гугла) решили, что эти сайты более хороши и присвоил авторство статей им. То есть в выдаче по запросам из статьи сайты находятся выше. Многие запросы просто улетели в топ 100, некоторые незначительно потеряли позиции.

«Обратите внимание, что мы не гарантируем учет вашей заявки в работе поисковых алгоритмов.»

Раньше мне было пофигу кто там и что с моих сайтов копирует. Мальчик наивно полагал, что ПС — умные машины, им не трудно после первой индексации статьи сохранить в БД дату и адрес сайта. Все это дело запомнить и поставить галочку «авторства».

Недавно я передумал

Выбрал самый наглый сайт, получающий хороший траф с моих статей. Написал письмо Платону и в поддержку хостинга, на котором тот сайт хостится.

Платоша, как и ожидалось, ответил:

К сожалению, поисковая система Яндекс является лишь зеркалом интернета, поэтому мы не правомочны разбираться в вопросах плагиата. Чтобы защитить свои авторские права, мы рекомендуем Вам обратиться к администратору указанного сайта и/или к провайдеру, на сервере которого он находится. Надеемся, что там Вам пойдут навстречу. Если сайт прекратит свое существование, он будет удален из поисковой базы Яндекса автоматически.

Да блин, дело тут вовсе не в вопросах плагиата, а в адекватной работе алгоритма. Если я опубликовал статью в 2010, а другой сайт ее же в 2012, нахрена вообще индексировать ее повторно? Ну ок, ок… пусть индексируется, но с пометкой – плагиат. Я бы на месте Яндекса вообще в выдаче такие сайты бы под спойлер загнал. Типа: «смотреть сайты с похожим контентом».

Ну да ладно… Учить Яндекс мне чему-либо, все равно, что учить сборную по футболу, как нужно играть, глядя на их игру по телевизору.

В хостинг направил такое письмо:

Здравствуйте!

Сайт «урл» нарушает авторские права. Ворует оригинальный контент с сайта «урл»

Статьи копируются один в один, даже картинки в статьях с нашего сайта грузятся.Пример:

— ворованная статья: *ссылка на статью вора*

— источник: *ссылка на мою статью*Таких статей довольно много. Публикуются они от автора: *урл*. Все последние статьи принадлежат нашему сайту.

Мы пробовали связаться с автором, но «e-mail для связи» на сайте нерабочий. Поэтому пишем Вам с просьбой предупредить автора. Пусть либо удаляет все наши статьи, либо в каждой статье проставит прямую индексируемую ссылку на статью-источник.

Просьба не игнорировать жалобу и принять меры.

Большое спасибо.

—

С Уважением, Александр.

Через время пришел ответ:

Данная жалоба передана владельцу сайтов. Если владелец прямо или косвенно признает факт нарушения авторских прав, сайты будут закрыты.

В противном случае Вам нужно будет обратится в суд, и предоставить нам постановление суда о приостановление обслуживания данного клиента.

Так же Вы можете во вне судебном порядке предоставить нам документы подтверждающие, что это Ваша интеллектуальная собственность.

Иными словами, меня могут послать в лес собирать опята, так как никаких документов у меня нет. Нормально

Но, уже через час все статьи, взятые с моего сайта были удалены. Либо хостинг написал действительно убедительное письмо, либо автор того сайта не всю еще совесть растерял.

Решил потратить время и проверить на уникальность все свои статьи, выявить гадов и написать письма. Все-таки, каждая неуникальная статья – это небольшой минус в огромное количество факторов, по которым ПС «решают» хороший сайт или не очень.

Проверка всех страниц сайта на уникальность

Если проверять каждую статью руками, уйдут годы. Поэтому я стал искать способ быстрой проверки. Рассмотрел несколько сервисов и программ – везде платить надо.

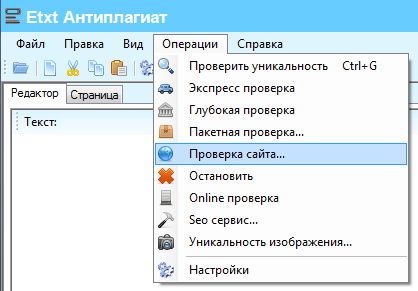

Но, кто ищет — тот найдет . Пакетно проверить уникальность всех статей на сайте поможет бесплатная программа Etxt Антиплагиат.

. Пакетно проверить уникальность всех статей на сайте поможет бесплатная программа Etxt Антиплагиат.

Разобраться в программе просто – все на русском языке. Но почему то, она у меня глючит. К примеру, не желает закачивать больше 40 страниц с сайта (потом парсинг вообще останавливается). Но не беда, я нашел, как этот глюк обойти. Распишу тут, как я проверяю:

1. Получил ссылки на все статьи сайта.

Просто зашел на страницу «Карта сайта» на своем сайте, затем в RDS-bar нажал Links и получил отчет – все внутренние и внешние ссылки со страницы. Скопировал все внутренние ссылки, удалил из списка ссылки на категории, главную и прочие ненужные для проверки страницы. Сохранил список в .txt файлик.

2. Операции – Проверка сайта.

Загрузил файлик, задал максимальное число страниц и ткнул «Проверить уникальность».

Чтобы не вводить каждый раз каптчи ПС руками, подключил antigate.com (смотрите в настройках программы).

Готово. По окончании тестов получил отчет с % уникальности каждой статьи и списком урлов на воров.

Теперь выявляем паразитов, пишем им письма (а лучше им и сразу в хостинг поддержку). Пусть или удаляют статью или ставят прямую индексируемую ссылку на статью-источник.

Также можно написать жалобу в Яндекс. В теме сообщения выбрать: «Сайт, нарушающий мои авторские права, находится по запросу выше моего» и подробно расписать о ситуации. Возможно, это что-то и даст, а может быть, и нет.

Всё это напрягает и отнимает кучу времени, но проблема наблюдается, и надо её решать. Бездействуя, мы отдаем свой трафик и поддерживаем воров. А они, глядя на свои успехи, начинают плодить все больше и больше говносайтов.

Далее поговорим о том, как сохранить уникальность и указать поисковым системам своё авторство.

Сохраняем уникальность статей на сайте

О том, как защитить контент много писать не буду. Написано уже много материала, но 100% защиты я так и не знаю.

Некоторые ставят на сайты скрипты, которые блокируют копирование текста пользователем или вообще выделение текста. Я считаю, это неправильно. Большинство юзеров копируют и выделяют текст не для того, чтобы скопипастить для других сайтов.

Таким образом, ставя такой блокирующий скрипт мы ухудшаем удобство работы пользователя с информацией. Сайт должен быть для людей.

Что можно сделать:

1. Каждую статью перед публикацией добавить в ЯВМ «Оригинальные тексты». (Теперь можно добавлять даже сайты с тИЦ 0)

2. Зарегистрировать аккаунт в Google+ и указать автора статей. Сам я еще этим не занимался, но скоро займусь. Вот вроде норм инструкция. (UPD: уже не актуально)

3. Можно поставить на сайт jQuery плагин для добавления ссылок в буфер обмена (сделал на нескольких сайтах – работает. Многие копипастеры оставили ссылку. Если с кодами возиться не хотите, то покупаем со скидкой по ссылке замечательный плагин (использую его на всех сайтах теперь): Clearfy Pro.

4. Отключить экспорт статей в RSS если он не нужен.

5. Вставлять ссылки в статье на другие страницы сайта. (Некоторые граберы даже не вырезают ссылки).

6. И, самое главное — как можно быстрее индексировать новые статьи. Для этого публикуйте ссылки в соц. сетях и сервисах (вконтакте, фейсбук, гугл+, твиттер и т.п). Можно настроить пред-публикацию (контент сначала доступен только по ссылке и лишь после индексации появляется на сайте и в RSS ленте).

7. Периодически следить за уникальностью статей.

Кто еще чего знает?

Отличная статья. Натолкнул на мысль о проверки некоторых молодых сайтов с небольшим трафиком но уникальными и ДОРОГИМИ статьями, по которым ох как не хочу терять трафик . etxt тоже использовал несколько раз и заметил, что практически с каждого сайта украли несколько текстов. Но, поскольку, это мне вреда не принесло (мои, все же были выше), то я никуда не жаловался.

. etxt тоже использовал несколько раз и заметил, что практически с каждого сайта украли несколько текстов. Но, поскольку, это мне вреда не принесло (мои, все же были выше), то я никуда не жаловался.

Сейчас можно в яндекс сообщить о новом материале.

Анонс в группу вк или прокаченный акк livejournal И статья полностью наша.

Также можно устанвоить скрипт от копирования

Да,как раз пользовался еткст антиплагиатом точно так же)

Долго,но корпит и работает)

Статья отличная и актуальная, автор лови плюс!

А я вот перестал бороться. Лучше всего добиваться быстрой индексации, а в дальнейшем, если копипастер выше, просто прокачивать свою страницу )

Но без лукавства скажу, что сейчас вообще не парюсь на эту тему.

Везет тебе. Я тоже раньше не парился

Я вообще не так делаю, заказываю кучу контента, делаю сайт, жду трафа. Траф пошел, начинаю немного покупать ссылки на некоторые страницы. А на то что ктото копирует эти статьи не обращаю внимания. Особенно в последнее время, есть аткой дорген СЕД, он берет текст с дескриптшена и тайтла, и они разлетаються по сотням доров… вот как тогда бороться? А дескриптшен то берется с текста статьи.

Уникальность соответственно никакая, но все держиться. Можна сказать кому как повезет.

Был случай когда с сайта закащика сперли тексты, написали хостеру вора, тот начал отнекиваться мол ничего незнаем. Тогда написали письмо со ссылками на даты индексации и цитатой из УК РФ, через пару часов сайт отключили.

если не сложно, цитатку бы посмотреть хотелось… возможно на будущее будет полезно знать

хотелось… возможно на будущее будет полезно знать

Отлично Чем больше узнаю о SEO, тем дальше ухожу в дремучий лес. Теперь ещё и из-за контента нужно переживать.

Чем больше узнаю о SEO, тем дальше ухожу в дремучий лес. Теперь ещё и из-за контента нужно переживать.

Чем больше узнаю SEO тем ближе мысли пойти на завод

Ты просто слишком мало знаешь про заводы, иначе и думать бы забыл о них, несмотря на гемор с сео

Может кто знает, такие роботсы спасают от автоматического парсинга? Например vashgarazh.com/robots.txt

В общем случае — нет.

Тоже думаю, что нет.

Нет. Этот файл смотрят только официальные поисковые боты, те, кто пишут простые скрипты-парсеры, имеют конкретную задача — получить контент, поэтому им на роботс плевать, это же просто .txt файл, который ни к чему никого не обязывает.

Да, статьи воруют постоянно. Не знал, что в etxt есть такая полезная функция, хотя пользуюсь не первый год. Хотелось бы пример письма позлее со ссылками на УК и т.д. владельцу сайта. Спасибо за статью, как раз на днях разбирался с такими же проблемами

Сразу же проверил несколько сайтов. Так, на одном почти половину украли и некоторые яндекс не просто показывает выше в выдаче, а индексирует только страницу-вора, а моей страницы с оригинальным текстом вообще нет %) Интересно…

Вот. Мы такие не одни

Пока у яндекса приоритет в определении авторства отдается трастовым ресам вся эта борьба только трата времени практически. Пока с одним хостером общаешься, уже еще воры появились и т.п.

Когда-то давно, несколько лет назад, пытался бороться, потом просто заебался и перестал, к счастью, не имею контентных проектов, сильно страдающих от кражи контента, если бы имел, пришлось бы тратишь дополнительно кучу времени.

выбор небольшой:

— писать админу сайта

— писать хостеру

в общем то больше ничего и не сделать. В суд подавать? Сколько времени уйдет на это, да и вариант что-то получить маловероятен. Если уж фильмы/программы у нас воруют, так с текстами тем более уж права защитить очень трудно. Autocad вроде борется усиленно с воровством их программ, но у них для этого люди специальные наняты. Будет ли вебмастер заниматься такой хренью? Врятле.

С одной стороны да, суд это долго, муторно и затратно. С другой, я думаю, после первого случая официального вызова в суд, вор в следующий раз 10 раз подумает, прежде чем тырить что-то.

Особенно, если вор это не крутой мегапроект со своим штатом юристов, а обычный «СДЛ» обычного человека, работающего дома в труселях.

статья очень даже вовремя, как раз вчера только я переписывался с Платоном по этой же проблеме. Вот как-то так:

Я

примеры страниц

> _http://1страница

> _http://2страница

> _http://3страница

>

> Доброе время суток.

>

> Есть статьи на сайте которых нет в выдаче, причем эти статьи есть на сайте _http://вор.

> к примеру статья на моем сайте _http://страница_моя была загружена 06.09.2011(проиндексировна чуть позже) а на другом сайте _http://вор_страница 10 августа 2012 была проиндексирована, т.е спустя год, после того как она появилась на моем сайте, но на моем сайте сейчас в индексе ее нет

############################################

Платон

Мы проверили, Ваш сайт присутствует в поиске и находится пользователями. Но часть страниц, действительно, отсутствует в результатах поиска, при этом никаких санкций на них не наложено.

Наши алгоритмы устроены так, чтобы на запросы пользователей давать наиболее полный ответ, и в связи с этим в результаты поиска попадают наиболее релевантные и уникальные страницы сайтов: см. _http://help.yandex.ru/webmaster/?id=1114408 .

О наших рекомендациях по развитию сайта Вы можете прочитать на следующих страницах:

_http://help.yandex.ru/webmaster/?id=1108944

_http://help.yandex.ru/webmaster/?id=1108945

При этом наш робот помнит о других страницах сайта; если на них присутствуют ссылки, он периодически переобходит их, и со временем они также могут быть включены в результаты поиска. Но, к сожалению, гарантировать включение тех или иных страниц в результаты поиска мы не можем.

#############################################

Я

если бы данные страницы не были бы релевантными то и на другом сайте их не должно было бы быть, это ведь понятно что по каким то причинам не мой сайт является первоисточником, а сайт который скопировал у меня спустя год, почему тогда на другом сайте мои статьи индексируются и участвуют в поиске?

#############################################

Платон

К сожалению, поисковая система Яндекс неправомочна разбирать вопросы, связанные с плагиатом. Для того, чтобы защитить свои авторские права, мы настоятельно рекомендуем Вам связаться с владельцами указанного Вами сайта или обратиться к провайдеру, на сервере которого расположен данный ресурс. Если по Вашему требованию информация будет удалена, при последующем посещении роботом этого сайта его страницы будут переиндексированы автоматически и ссылки будут удалены из результатов поиска.

Единственное пока не писал хостингу

Читай между строк: игнорирует такое понятие как «авторское право»

игнорирует такое понятие как «авторское право»

Если украденная статья больше подходит контенту, тематике и т.д. сайта вора, то яндексу, грубо говоря, пофиг на авторство и авторские права, он отдаст предпочтению этому сайт и этой странице. То есть, если пользователь (по мнению алгоритмов ПС) на сайте, который украл текст, может найти больше интересующей его информации, то он будет выше в выдаче.

Грубо говоря, яндекс вполне обдуманно и даже немного специально

Вот бы всем вебмастерам собраться да и подать в суд на Яндекс, например, по статье «распространение незаконного контента» или «соучастие в мошенничестве». Тогда, может, что-то и изменилось. Сама получала такую же отписку и считаю, что так говорить, все равно, что фирма, продающая ворованные машины, оправдывалась бы тем, что они «ближе к метро» и вообще удобнее для пользователей. Только с машинами не прокатило бы и все сели, почему с ворованными текстами прокатывает, не могу понять.

по поводу проверки сайта на уникальность через etxt, раньше тоже был глюк что проверяет меньше страниц, решался просто — сначала указываешь максимальное кол-во страниц и только потом загружаешь страницы, хотя возможно сейчас как-то по другому

Тоже занялся помнится борьбой. Увидел, что с моего сайта подчистую воруют статьи, даже служебные страницы, отключил нафиг rss — он помогает автоматизировать воровство.

Написал десятку владельцев сайтов-воров, они обычно не отвечают, но после письма в хостинг-компанию, либо принимают меры, либо посылают в суд. В итоге порядка 7 сайтов, сделанных школотой, закрыли, т.к. они состояли только из моих статей.

Одному жирному сайту написал тоже о воровстве, а они ответили:

«Если контент в интернете, то не значит что он стал вашим и т.п.»

Я ответил, что вообще-то эти статьи пишет моя журналистка за мои деньги, а они ответили, что больше не будут, но то что взяли удалять не собираются. И что было делать? В суд подать и встрять на гемор на полгода, чтобы наказать одного дебила? А в это время еще десяток дебилов сидят копи-пастят и радуются, что на бутылку пива заработали на ворованных статьях.

Я просто заблокировал доступ для их сервера на мой сайт, явно ведь граббер работал.

Трудно с этим в рунете, если бы была хоть одна показательная порка — осудили бы за воровство и посадили, сразу бы в 2 раза меньше другие воровать стали.

Один раз у меня весь дизайн у сайта украли (дизайн был заказной, качественный) и на сайте вор написал: «Как вам мой новый дизайн? Сам делал.»

Я написал вору и хостеру, хостер послал меня в суд.

Я ответил хостеру, что я опытный вебмастер уже 10 лет и сделаю их хостингу такую репутацию, что они о клиентах забудут… Хостеры два раза извинились (менеджер и старший менеджер) и немедленно удалили сайт вора полностью, но думаю, это единичное везение.

Один мой друг (владелец суши-бара и магазина) мне так сказал: «Если все время оглядываться назад и сожалеть о том, кто и что у тебя украл, то денег не заработаешь.» Я следую его принципу. Думаю, в рунете по большому счету гоняться за ворами, что-то даст, но отнимет все время от основной работы.

иногда бывает просто очень грустно из-за воровства. у меня например на сайте из 3000 страниц осталось 500 в индексе яши. А я ссылки продаю с этого сайта, и расклад может быть такой, что я потратил на этот сайт больше чем успел заработать и это как-то печально.

УРЛ «жирного» (я бы сказал, зажравшегося) сайта в студию.

«Я просто заблокировал доступ для их сервера на мой сайт, явно ведь граббер работал.»

Это обходится легче легкого, если нужно.

Это я понимаю, что можно обойти блокировку IP легко.

А сайт их, насколько я помню: lred.ru (помню точно, что редлайн из Хабаровска) — там у них есть база знаний — огромный каталог ворованных статей. Думаю, другие тоже найдут свои статьи у них…

сайт что то не открывается(

У меня открывается нормально, только не сразу.

Случай из моей недавней истории. Пробил уникальность, 20 статей на каждую из которую я потратил ни один день на написание, была полностью скопирована на другой блог. Написал владельцу, тот отказался удалять. Мотивируя это тем, что не может и объяснять причину не видит смысла. Нет и все. «Разговор окончен». В общем, очень упрямый попался. «Статьи публиковали ньюсмейкеры и выявлять чье авторство — нет никакого желания». Скинул ссылку на кеш Яндекса, где видно, кто автор. Не помогло — не буду удалять и все тут.

Написал хостингу — через день владелец сам написал и сказал, что удалит статьи. Удалил. Так что сразу же, после того как владелец сайта отказывается удалять статьи — пишем хостингу. И не тратим много времени на переписку.

По поводу защиты контента, бурундук пару лет назад на серче продавал тему как защищаться, чтобы Ваш считали всегда первым.

Как один из методов, это в статьи вставлять ссылки на другие страницы, и делать их тоже черным и без подчеркивания. В основном люди копируют через ворд и потом вставляют к себе на сайт и получается 3 ссылки бесплатные с каждой сворованной страницы

думаю что это наиболее эффективный метод, но есть НО…

я сам очень часто писал на заказ программы парсеры, которые грабили контент с определенного сайта, правда там они собирали не статьи, а товары и характеристики к ним. Т.е стояла задача, чтоб программа весь каталог собрала в базу(актуально когда товаров сотни и тысячи). Так вот, зная что каждый товар в ручную проверяться не будет, я все описания к товарам чистил от html тэгов, так что ссылок не оставалось.

От тех кто грабит через парсеры(а таких вроде как много) нужно защищаться тоже как-то.

Сейчас пришла такая идея. Предполагая что все парсеры умею очищать от тэгов можно сделать в статьях некую конструкцию, которая немного усложнит очистку:

например в середине статьи сделать вставку источник: domen.ltd

т.е данного блока не видно, на оптимизацию страницу также не должно влиять, но при очистке от тэгов останется «источник: domen.ltd» это конечно не прямая ссылка, но все же заставит вора редактировать все статьи которые украл.

По поводу простановки активной ссылки на источник.

После моего письма владельцу сайта, они поставили активную ссылку. Спустя 4 месяца сайт продолжал по части запросов ранжироваться выше первоисточника. После письма в Яндекс, они ответили что они не причем, после этого вроде бы наш сайт стал выводится вместе копипастера.

На счет быстрой индексации статьи согласен! Был случай как на одном моем сайте быстро своровал один чел только что появившуюся статью и у него на сайте она моментально проиндексировалась. Получилось, что у него оригинал, а не у меня. После этого случая теперь каждую статью (а точнее ее урл) сразу же после публикации на сайте добавляю в твиттер.

Уроды блин, если не сказать жестче. Народ горбатится работает не спит ночами, фототки делает, а тут находится малолетний умник который возамнил себя гуру и хруначит копи-паст, руки бы оторвал. У меня были несколь ко проектов которые реально от этого пострадали.

Добавлю и свои «пять копеек» в защиту контента.

Народ пишите статьи связанные с фото, то есть если вырезать из статьи фотки то смысл теряется. Допустим пишите про ноут. Описываете его и говорите — вот на фотке вы можете видеть уникальную крышку, кнопки и т.д. В свою очередь на фотке размещайте логотип своего сайта. Причем размещайте так чтобы его нельзя было закрасить удалить. Если очередной молокосос копи-пастер, скопирует текстовый контент, то читать его без фоток будет не возможно, а вот если скопирует с фотками, так ваш водный знак, так что народ будет понимать с какого сайта эта инфа, как то так!

если он собирает сателит для продажи ссылок, то ему пофиг будет на твою картинку и что статья без нее не читаема

Согласен с Сергеем.

Делать статьи с изображением и накладывать на них водянной знак. Желание у воров воровать такие статьи поубавится.

А так конечно неприятно когда тратишь много времени на написание статьи, а какой-то умник копирует себе на сайт, затем поисковик ставит их выше в поиске. Странно, что поисковики так плохо определяют первоисточник, не думаю, что это так сложно ставить выше ту страницу, которая раньше попала в индекс, а дублям присваивать какую-нибудь метку, например дубль два, три и т. д и добавить трасту оригиналу, как интересной статье — раз ее дублируют другие сайты.

Ох, сейчас ворам даже на это плевать. И быстрая индексация не помогает. Я заметила ( у меня кулинарный с уникальными фото), как рецепт стал проседать, значит, кто-то украл мою статью. И точно, ищу по текст ру, еткст, на мой взгляд, хуже ищет — и рерайты не очень видит, а иногда и полные копии. Нагло воруют и фотки с водяными знаками. Да, без проблем можно из Гугла удалить по заявке, если фотки со знаками, а вот Яндексу все равно плевать. И еще утверждают, что у них есть ручная модерация. Неужели модераторы не видят, что все статьи на сайте с фотками и водяными знаками с других сайтов. Почему это копипастное говно никто не блокирует?

Соц сети, соц сети точно помогают решить эту проблему, потому как поисковики быстро оттуда информацию забирают зачастую. Вообще конечно на своей практике не сталкивался с тем, что бы конкурент с моим текстом стал выше. Видимо везло.

Ну что я могу сказать, нужно ловить быстро робота и держать его у себя.

На последних сайтах, после создания, начинаю постить записи и сразу добавляю в addurl, а так же публикую очень часто, что бы робот знал что надо заходить ко мне.

Для вордпрес есть плагин WP-CopyProtect он поможет

Подскажите а как узнать что быстро робот зашел на мой сайт?

по логам заходов. Я например не использую cms, делаю все сам с нуля и в своем движке создал функцию, с помощью которой можно посмотреть когда и на какую страницу заходил робот яндекса или гугла. Данная функция очень выручила когда анонсы статей своих куда нить кидал. Если ты используешь cms то тебе придеться ставить модуль, я например встречал однаждый плагин для wp, название не помню но вроде в названии было слово fire причем он универсальный был, для разных движков и бесплатный.

Так и не понял как добавить на сайт «jQuery плагин для добавления ссылок в буфер обмена». Не подскажите?

Примерно так было и с моим проектом, только вот топ занял вовсе не пузатый сайт.

«О том, как защитить контент много писать не буду» нормально чо, думал почитаю действительно что то стоящее…

Все ошибаются, чо.

Вставлю свои 5 копеек. Моя борьба с предотвращением сабжа, сводится к 3 пунктам.

1. Установка скрипта (который добавляет ссылку в конце текста, при копировании.)

2. Размещение страницы «Копипастерам» со страшными предсказаниями о том, что есть на свете анальный самурай, и он может покарать

3. Проверяю ежемесячно, тем же Etxt.

Пусть это не панацея, но кого-то это остановит.

У меня тоже был сайт-СДЛ по новинкам электроники, новостям ИТ. Все статьи заказные или написаны мной. ДА ДА я злой…

ДА ДА я злой…

Один умник cijman. ru выпарсил почти полность и разместил у себя.

Когда ему написал так он мой ИП заблокировал. Пришлось писать хостеру и пояснять что и откуда стырено. Вроде все убрал с этого сайта.

ТАк появились еще дубли.. Хостинг на украине. На сайте нет контактов. Хостер посылает в УКРАИНСКИЙ СУД.

Вот думаю расчехлить хрумер что ли? И прогнать по базе абузных форумов

Решать только тебе. Но надо стремиться быть хорошим

Спасибо огромнейшее тебе автор за ссылку на прогу Антиплагиат, особенно за то что есть её версия под Linux! Но всё же хотелось бы узнать про результативность защиты контента кнопкой Google+ и добавления статьи в ЯВМ. Да и как это можно было бы автоматизировать (в том плане если не для себя стараешься).

Можно написать скрипт, который автоматом в ЯВМ постит. У меня свой скрипт, в который копирайтер постит статью, кликает кнопку и статья добавляется в ЯВМ.

покупай тачку и делай обзор на сво

Что за сво?

Я отключаю RSS и все. Мне, пока, этого достаточно.

Мне, пока, этого достаточно.

Отключение RSS спасет только от потока нубов. А те кто занимается этим постоянно — имеют совсем другие инструменты для граббинга.

Познавательная статья! Спасибо!

Мало того, что мы работаем над своими сайтами, пишем уникальные и полезные статьи, так еще и должны бороться с мошенниками! Я поражаюсь, что Яндекс не в силах или не хочет помогать вебмастерам. Надеюсь в скором времени ситуация улучшится!

Прошло 7 лет!!!! А воз и ныне там! Дополню, яндекс на нас с вами зарабатывает, но на вебмастеров он ложил… Надо в суд на яндекс подавать и не бегать за ворами, поскольку эту безумие. Судиться с сотнями воров, которые к тому же могут находиться в других странах..! Если бы яндекс не индексировал чужие тексты, то и воровать бы не было смысла и эта «лавочка» стала бы не актуальной, поэтому считаю, что только на яндексе лечит вся вина абсурдой действительности!

Можно немного перевести трафика с сайтов воров на свой.

Если статья сворована вместе с картинками и они подгружаются с нашего сайта, то можно отредактировать свою статью — заменить в ней адреса картинок, а по старым адресам разместить картинки с надписью «чтобы посмотреть скрин переходите на сайт источник».

Ребята воровство контента обычно происходит на автомате тоесть прого лазиет ищет контент по ключам и ворует его и постит в куда указанно.Так вот История написал я 5 статей поместил их на сайт и уехал в камондировку успел только сайт в индекс гугла загнать и все не сылок ни чего не ставил .но перед отездам поставил плагин один на вордпресс суть у него такая кагда с копировали ваш контент плагин размещяет в конце поста сылку откуда взят контент .Так вот через 2,5 месеца я приехал и увидел что мой сайт в топе уже у гугла и вебмастер гугла показал 479 сылок на мой сай.И всё это пи…. контент с моего сайта.Так что Граждане ни чего страшного и нет если ваш друг разместил этот плагин то сейчас стояла бы сылка с пузана на сайт вашего друга и пс считали бы статью просто дубликатом.Если хотите я гляну как называется плагин

Напиши как плагин называется

да, напиши прагин

Собщение в ПС о том, что сайт, копирующий контент, находится выше вашего в поисковой выдаче сработает только если этот сайт сравним по параметрам с вашим. Но если сайт значительно старше, имеет больше контента, пуза и пр., то это напрасная трата времени и нервов.

Alex, напиши, пожалуйста, как тот плагин называется, который добавляет в конце ссылку на сайт-первоисточник при копировании. Ждем.

Когда сам картинки с адалт сайтов тырил — всё нормуль было, как у тебя контент сграбили — уже «Воры и Подлецы». Проще надо относиться и воздерживаться от таких крайних оценок.

Тем более, что картинки на твоих статейниках тоже откуда-то ворованные. Ты же не сам фотографии к статьям делаешь? Правильно — не сам…

Я бы хотел проще относиться. Мне действительно не жалко — пусть бы воровали, но ПС делает так, что приходится задуматься и бороться.

Часть картинок беру с фотостоков, часть в гугл. картинки, и совсем маленький процент своих) Это конечно неправильно тоже, но ущерба вроде никому это не приносит.

Сегодня приняли закон в Гос Думе, но попробуй докажи, особенно если это статьи… насчет аудио видео также сайтов миллионы все не закроеш они всеравно переедут на новые домены

На новые домены и в новые страны, там например в Китай или еще куда…

Да обидно. Но порой мне кажется пороноей все это!!! А у меня украли. А авторские права, плагиат, и пошло поехала. В караоке придете авторские права, сексом будите заниматься тоже авторские права!!!

Когда сайты «воров» по запросам находятся выше твоего — это не паранойя. А суровая несправедливость, которую приходится исправлять.

Дело в том, друзья, что сам Яндекс со своими островами, будет являтся вором чужого контента)))

Единственный вариант — вливатся в срезу вора, знакомится с ним, узнать ео адрес, купить пистолет — и в один момент свершить правосудие!

Так в итоге же юзер всеравно переходит на сайт по островам. Тут проблема в том, что нам, как владельцам информационных проектов, коммерческие сайты с такими островами доставляют неудобства.

Прочитал, согласен, из-за халявщиков у нормальных ребят, наполняющих свой сайт проблемы с позициями. Не справедливо…

%) воровать чужие статьи плохо, да и не полезно

с момента появлении статьи очень долго думал о том как защитить статьи и о том как находят их воры, когда например у сайта посещаемость низкая и монетизации нет. И вот нашел фишку, с помощью которой можно найти сайт у которого можно скопировать статьи, которые легко войдут в индекс. Фишку палить не буду, пока. Хочу сначала полностью убедиться в этом. Среди присутствующих есть кто подобное знает?

«А у тебя есть штучка? Такая штучка.»

«Какая, такая штучка?»

«Ну штучка!»

(с) Масяня

Мы тебя поняли великий мудрец

Думаю, самое эффективное в борьбе за авторство — ставить ссылку в тексте.

Сань, скажи, а почему не сделать запрет копирования мышью и CTRL+C?

Просто смотрю многие статьи (или части статей) расползаются по сервисам типа «Ответы Mail.ru». То есть контент тырят конечные пользователи, а не вебмастера. Mail.ru ранжируется, разумеется, выше и как выпилить оттуда статью непонятно.

Что думаешь по этому поводу?

Очень не полезно это, самому так сказать в убыток

Если вы, как бы выразиться, обладаете очень специфическим в рамках темы контентом (например, изобрели оригинально новый метод повышения ТИЦ), и у вас есть десяток верных друзей-блоггеров, можно попросить их закидать «скопипастенную» статью насмешливо-ядовитыми комментами типа «да вы поняли, что написали? не позорьтесь! да все сеошники умирают о хохота» и т.п. Конечно, работать будет в некоторых случаях, когда «война» идет между «камерными» проектами типа блогов.

Сам встречался с подобной проблемой. Ни к кому не обращался, никаких писем не писал. По своем глупости и непросвещенности в данном вопросе, просто удалял подобные статьи с сайта. Заметил, у себя такую тенденцию, статьи воровали только после взлома своего сайта. Теперь я стал немножко умнее и только что опубликованный материал прогоняю по всем социальным сетям. Затем повторяю это действия спустя 1-2 недели. Кстати, сайты, проявляющие слишком высокую, подозрительную активность, вношу в черный список.

Приветствую, Александр! Очень хотелось бы знать Ваше мнение: Многие интересные статьи моего сайта скопированы в группы и страницы вконтакте, без указания источника. Масштаб копипаста впечатляющий, одну удачную статью могли разместить от 200-500 юзеров на своей странице и десятки групп с 0,5-3 миллионами участников. Как это может повлиять на ранжирование сайта? (по поиску текста зачастую уже выдается не сайт, а вк). Проблема массовая.

Привет! Ничего хорошего в этом нет, увы. ПС — не идеальны. Я часто замечаю такое, что сворованные статьи вдруг теряют позиции или вообще вылетают из индекса. Потом в поиске по запросам в топе те, кто статью скопировал.

уволок статью, увеличил пробелы между словами. вуаля, проверка показывает уникальность от 70 до 100%. далее в яше вбил текст на уникальность и всё прокатывает.

В данный момент яндекс как и гугл, стали по строже относиться к воровству, так что можно писать они примут меры. Но если сделать что бы сам сайт хорошо и быстро индексировался, то проблем с воровством можно избежать, так как в основном яндекс и гугл думают так, у кого первого новая страница проиндексировалась, тот и автор.

Сам в своё время делал копипаст. Как итог — авторы статей всегда связывались со мной, чтобы я удалил статьи. Все сайты на копипасте уходят в АГС. Поэтому пишите качественный и уникальный контент. Скажем копипасту «НЕТ»!

В сентябре сайт улетел от фильтра Панды. На форуме гугла мне намекнули что много рекламы. Убрал, а траф и позиции не возвращаются. Сейчас вот взялся анализировать, а статьи растасканы, причём вместе с фотографиями с водяным знаком, единицы проставили ссылку. В принципе если воруют, но это на тебе не сказывается, Бог с ним, но когда ты на 180-м месте, а украденная статья в топе, а по куску текста из статьи, на первом, а тебя вообще нет? Вроде в гугле где-то было пожаловаться, но найти не могу. Вручную конечно понимаю что это море работы, особенно если нет контактов и хостинг забугорный, но как-то выходить из ситуации надо. Переписывать статьи не вариант, яндекс нормально вроде к сайту дышит.

Прогнал файл с внутр.ссылками через Etxt, их там 548 штук. В итоге проверки Етхт выдал:

Итог пакетной проверки (20 из 20):

Так и должно выдаваться 20 результатов?

А ты точно ввел «максимальное число страниц»? Глянь скрин:

Ага. Внутренних ссылок насчиталось 548, в настройках выставил 550.

Сейчас еще разок попробую

Ну как успех? Получилось, не?

Пробовал три раза. Все равно показывает только 20..

Специально только что проверил. Все сработало (22 из 22 проверилось).

Еще раз проверь:

— сначала указываешь максимальное число страниц

— потом жмешь Загрузить из файла.

И обнови прогу (если не последнюю версию используешь).

Сделал все так, как ты написал и поперло))

Я закрывал плагином от воровства, а если тырили, то отсеживал

Вот этот сайт _melochi-jizni.ru ворует статьи с других сайтов. Когда регистрируешься у них и задаешь вопрос, по поводу моей статьи что они разместили без ссылки, так тут же блокируют аккаут.

Вопрос всегда оставался актуальным. Лично я поставил скрипт (простейший JS) добавляющий ссылку в буфер обмена, добавляю в ЯВБ уникальные тексты перед публикацией, делаю внутреннюю перелинковку… Пока этого хватает. Да и воруют у меня редко.

Однажды обнаружил свою статью на другом сайте, мыла для связи с автором не нашел даже через Whois.

Мне кажется бороться с воровством контента с вашего сайта просто бесполезно. Нужно с этим смириться. Раз ты выложил текст (или прочую информацию) в сеть Интернет, значит любой посетитель сайта может пользоваться этим по своему личному усмотрению. Читать, сохранять к себе на комп, копировать на свой сайт и всё остальное, что душе заблагорассудится.

В корне не верно. Так, если ты на улицу вышел, то уже себе не принадлежишь что-ли?

Я если честно в шоке что через 2 года украли статью и оказались выше — до этого был уверен что после индексации то уж точно ничего не грозит) Хотя если это было 12-13 гг то может что то изменилось на сегодняшний день. Хотя бы в гугл, на яндекс и не надеюсь